Facebook-Crash am 24. Juni 2025: Tausende Gruppen verschwunden – auch Wortfilter betroffen

Am 24. Juni 2025 war es plötzlich still in vielen Facebook-Gruppen: Über Nacht verschwanden zehntausende Communitys weltweit – ohne Vorwarnung, ohne Erklärung. Auch die Wortfilter-Facebook-Gruppe war betroffen. Was wie ein gezielter Angriff wirkte, stellte sich später als technischer Fehler bei Meta heraus. Doch die Auswirkungen waren massiv – und werfen erneut die Frage auf, ob Facebooks automatisierte Moderationssysteme tragbar sind.

Was ist passiert?

Laut Meta wurde am Morgen des 24. Juni ein „technischer Fehler“ festgestellt, der dazu führte, dass Facebook-Gruppen massenhaft gelöscht oder gesperrt wurden. Betroffen waren Gruppen jeder Größe – von kleinen Hobbygruppen bis zu internationalen Netzwerken mit Millionen Mitgliedern.

Auch harmlose Gruppen erhielten plötzliche Vorwürfe wie:

- Verstoß gegen Gemeinschaftsstandards

- Unterstützung von Terrorismus

- Nacktheit oder Hassrede

Beweise? Fehlanzeige. In vielen Fällen wurden Gruppenadmins zusätzlich aus ihren privaten Accounts ausgesperrt. Die Beschwerden häuften sich innerhalb von Stunden auf Reddit, X, TikTok und in Petition-Plattformen.

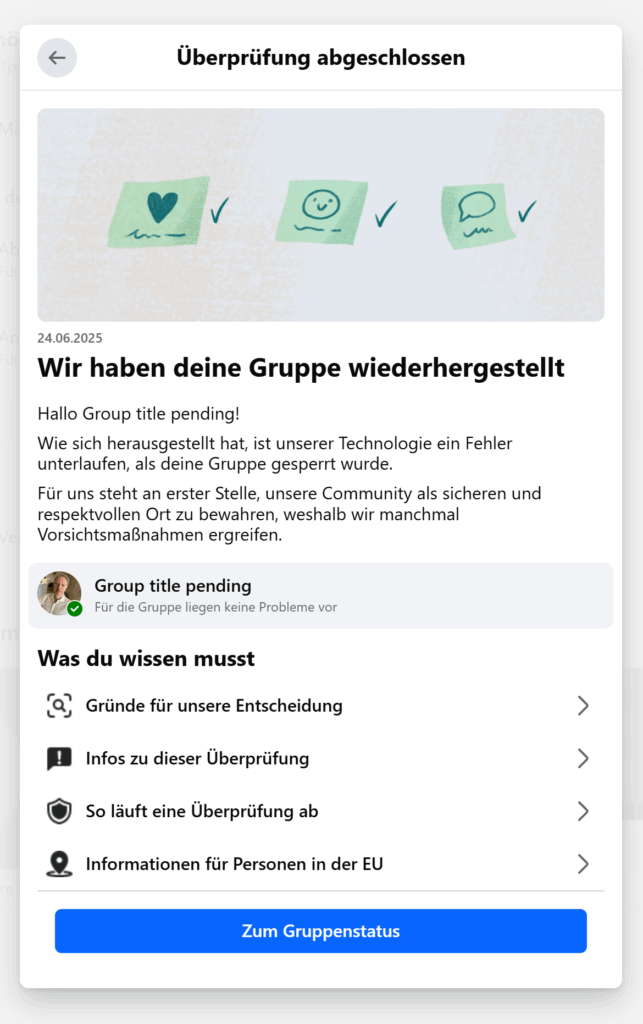

„Group title pending“: Rückkehr mit neuem Namen

Einige Gruppen tauchten im Laufe des Tages wieder auf – allerdings unter dem seltsamen Namen „Group title pending“. Das klingt harmlos, hat aber gravierende Folgen: Laut Facebook ist eine Gruppen-Umbenennung nur alle 28 Tage möglich. Bedeutet: Für fast einen Monat ist die Community faktisch entstellt – auch in der Wortfilter-Gruppe.

Die Sichtbarkeit leidet, das Vertrauen ebenso.

Wortfilter war selbst betroffen

Auch die Wortfilter-Facebook-Gruppe, in der zehntausende Händler, Plattformexperten und E-Commerce-Profis diskutieren, wurde ohne Vorwarnung gesperrt. Der Gruppenname wurde auf „Group title pending“ gesetzt, Inhalte waren zeitweise nicht erreichbar.

Das ist besonders kritisch, da diese Gruppe für viele ein täglicher Ankerpunkt ist – ein Ort für News, Austausch und gegenseitige Hilfe.

Die Ursache: Künstliche Intelligenz außer Kontrolle?

Laut einem Bericht von NPR aus dem Mai setzt Meta zunehmend auf automatisierte Moderation durch KI. Ziel: Risikoerkennung durch maschinelles Lernen. Doch genau dieses System scheint nun falsch positive Treffer in Serie produziert zu haben.

Einige Nutzer vermuten, dass koordinierte Bot-Angriffe das Meldesystem manipulierten und dadurch Massenlöschungen auslösten. Andere vermuten politische Filter, gezielte Unterdrückung bestimmter Gruppen – LGBTQ+, pro-/anti-Trump, pro-Palästina etc. Klar ist nur: Meta schweigt.

Petition gegen Meta – der Druck wächst

Eine Change.org-Petition unter dem Titel „Hold Meta Accountable“ sammelte innerhalb von 24 Stunden über 14.000 Unterschriften. Die Forderungen:

- Menschliche Überprüfung von Sperren

- Transparente Begründungen

- Fairer und schneller Einspruchsprozess

- Abschaffung der KI-Alleinentscheidung

Wiederholungstäter Meta: Es ist nicht das erste Mal

Die Massenlöschung vom Juni 2025 ist kein Einzelfall:

- Juni 2025: Zehntausende koreanische Instagram-Accounts wurden ohne Begründung gesperrt

- Februar 2024: Hacker nutzten Oculus-Zugänge, um Facebook-Accounts zu übernehmen

- März 2021: Löschung tausender Gruppen im Zusammenhang mit Wahlbetrugs- und Impf-Desinformationen

- 2021 und früher: Mehrfach Wellen an Sperrungen politischer Inhalte und Gruppen

Fazit: Vertrauen in Facebook? Wieder erschüttert

Der Vorfall zeigt erneut: Die technische Infrastruktur von Meta ist nicht robust genug, um verantwortungsvoll mit Millionen Communities weltweit umzugehen. Der Kontrollverlust über die eigene KI und die fehlende menschliche Korrektur sind gefährlich – nicht nur für politische Gruppen, sondern auch für einfache Nutzer und Fachcommunities wie Wortfilter.

Für E-Commerce-Unternehmer, die Facebook-Gruppen für Kundensupport, Community-Aufbau oder Reichweite nutzen, ist das ein Alarmsignal: Jede Community auf fremder Plattform bleibt angreifbar.

Deshalb die Empfehlung:

- Gruppen extern sichern (z. B. E-Mail-Backups, Screenshot-Archive)

- Parallele Communities aufbauen (z. B. Discord, LinkedIn, Mastodon)

- Kritische Inhalte zusätzlich auf eigenen Kanälen veröffentlichen (Website, Newsletter)

Denn wer seine Community nur auf Meta aufbaut, baut auf Sand. Und das trifft auch auf Wortfilter zu.